批流一體大數據分析架構的設計與實現

在當今數據驅動的時代,企業對數據處理能力的要求日益提高。批流一體架構能夠同時處理實時數據和批量數據,為企業提供快速、準確的數據洞察。本文將介紹批流一體大數據分析架構的搭建流程,重點涵蓋數據處理和存儲支持服務的設計。

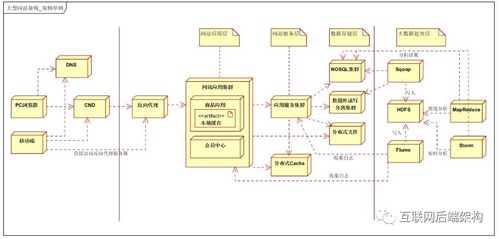

1. 架構概述

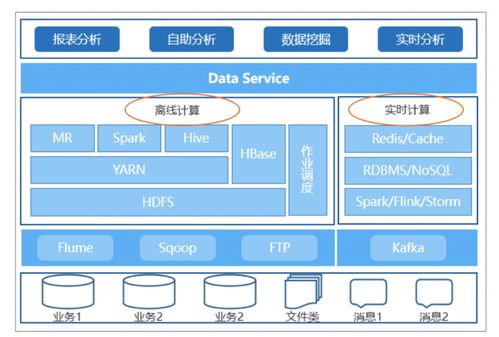

批流一體架構融合了批量處理和流式處理的優勢,通過統一的數據模型和工具鏈,實現數據的統一采集、處理與存儲。核心思想是構建一個既能處理歷史批量數據,又能處理實時數據流的平臺,使得數據分析任務能夠無縫切換或并行執行。

2. 數據處理層設計

數據處理層是批流一體架構的核心,負責數據的接入、清洗、轉換和計算。常見的組件包括:

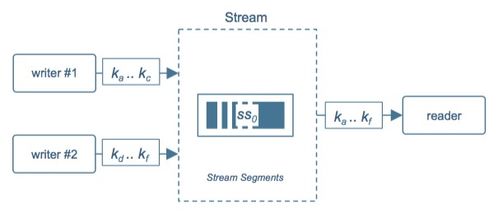

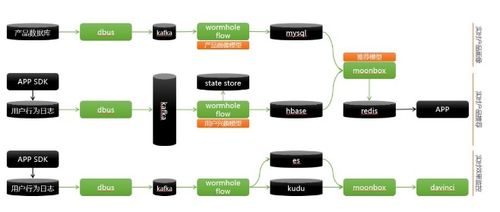

- 數據接入工具:如Apache Kafka或Pulsar,用于實時數據流接入;Apache Sqoop或Flume可用于批量數據導入。

- 計算引擎:推薦使用Apache Flink或Spark,它們天然支持批流統一處理。Flink以其低延遲和狀態管理能力著稱,適合復雜的實時計算;Spark則提供強大的批處理能力,并通過Structured Streaming擴展流處理功能。

- 數據處理框架:采用Lambda架構或Kappa架構。Lambda架構結合批處理和流處理層,適合高可靠性場景;Kappa架構則簡化設計,僅依賴流處理,通過重播數據實現批處理。

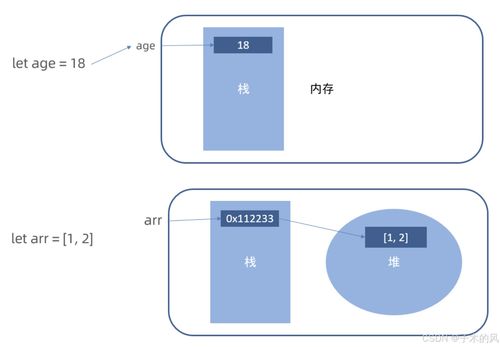

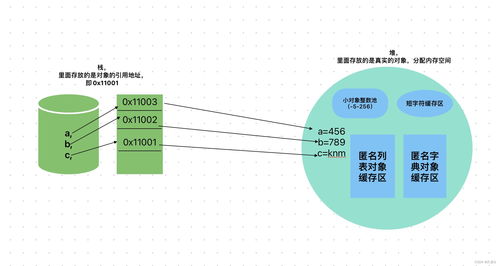

在實施中,需定義統一的數據格式(如Avro或Parquet),確保批流數據的一致性。例如,使用Flink的Table API或Spark的DataFrame API,編寫統一的SQL或代碼邏輯處理數據。

3. 數據存儲層設計

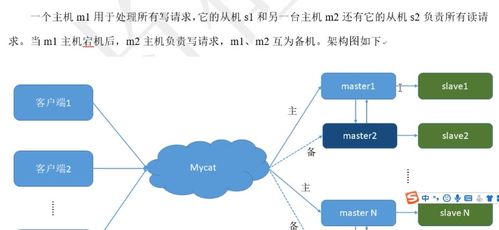

數據存儲層需要支持高吞吐、低延遲的讀寫,并兼容批流數據。常見存儲方案包括:

- 實時存儲:使用NoSQL數據庫如Apache HBase或Cassandra,用于快速查詢實時結果;緩存系統如Redis可加速熱點數據訪問。

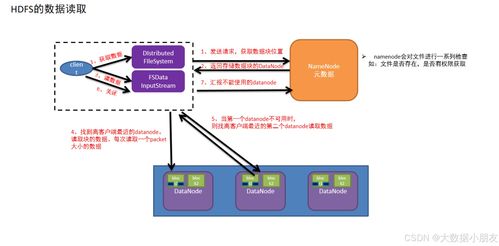

- 批量存儲:數據湖技術如Apache HDFS或云存儲(如AWS S3),用于存儲原始批量數據和歷史快照。

- 統一存儲層:采用數據湖house概念,結合Delta Lake或Apache Iceberg,提供ACID事務和版本控制,實現批流數據的統一管理。這些工具支持在同一個存儲系統中處理實時更新和批量數據,簡化數據治理。

存儲設計時,需考慮數據分區和索引策略,以優化查詢性能。例如,按時間分區可加速時間范圍查詢,同時支持實時流數據的追加和批量數據的覆蓋。

4. 支持服務與工具集成

為了確保架構的穩定性和可擴展性,需要集成支持服務:

- 元數據管理:使用Apache Atlas或DataHub,跟蹤數據血緣和治理,確保數據質量。

- 調度與編排:工具如Apache Airflow或Dagster,用于協調批處理和流處理任務,實現自動化流水線。

- 監控與告警:集成Prometheus和Grafana,監控數據處理延遲和資源使用情況,及時發現問題。

- 安全與權限:通過Kerberos或Apache Ranger實施訪問控制,保護敏感數據。

云平臺服務(如AWS Kinesis for streaming和EMR for batch)可以簡化部署,提供托管解決方案。

5. 實施步驟與最佳實踐

搭建批流一體架構時,建議按以下步驟進行:

- 需求分析:明確業務場景,如實時推薦或歷史報表,確定數據處理延遲和準確性要求。

- 組件選型:根據團隊技能和基礎設施,選擇適合的計算引擎和存儲系統。從小規模試點開始,逐步擴展。

- 數據建模:設計統一的數據模式,使用事件時間處理來對齊批流數據,避免時間不一致問題。

- 測試與優化:模擬高負載場景,調優資源配置(如并行度和內存分配),并實施數據備份和容錯機制。

- 持續迭代:通過監控反饋,不斷優化架構,適應業務變化。

批流一體大數據分析架構通過統一的數據處理與存儲層,能夠高效支撐復雜的數據需求。實施時,注重組件集成和數據一致性,將顯著提升企業的數據分析能力。

如若轉載,請注明出處:http://www.fsqm.com.cn/product/13.html

更新時間:2026-01-12 17:50:08